1. Systèmes de fichiers distribuĂŠs▲

Cette version est une version allÊgÊe de mon livre sur le cloud computing. La version complète se trouve ici.

Un système de fichiers distribuÊ est un système oÚ le poste client accède à un espace de stockage virtuel unique. Les donnÊes peuvent être rÊparties/dupliquÊs sur plusieurs machines de façon transparente pour celui-ci. C'est le moteur du système de fichiers distribuÊ qui a la charge de rÊpartir les donnÊes et de les dispatcher au client.

Les systèmes de fichier distribuÊs les plus rÊpandus sont :

- CephCeph ;

- GlusterFSGlusterFSÂ ;

- Hadoop Distributed File System (HDFS)Â ;

- Lustre (utilisĂŠ par les super-calculateurs)Â ;

- NFSNFS - Network File System.

Sur les tests effectuÊs, il ressort deux approches :

- une approche en blocs (chunks) rÊpartis sur plusieurs machines et pour lesquels les mÊtadonnÊes peuvent être centralisÊes ou distribuÊes et permettent de reconstruire les fichiers ;

- une approche reposant sur la notion de fichiers et utilisant ou non des mĂŠtadonnĂŠes. Certains nĂŠcessitent d'avoir une ou plusieurs machines dĂŠdiĂŠes aux mĂŠtadonnĂŠes, d'autres permettant d'intĂŠgrer les mĂŠtadonnĂŠes sur les machines stockant les donnĂŠes, ou ĂŠventuellement sur des machines autonomes.

Ceci a un impact sur le minimum de machines requis pour crĂŠer le système de fichiers distribuĂŠs, sur la souplesse de retrait et dâajout de machine, sur les performances, la maintenance et la sauvegarde.

Ce tutoriel couvre les systèmes de fichiers suivants :

- GlusterFSÂ ;

- OCFS2 couplĂŠ Ă DRBDÂ ;

- Ceph ;

- Minio.

En rÊalitÊ, OCFS2 (Oracle Cluster File System) n'est pas un système de fichiers distribuÊ, mais un système de fichiers gÊrant la concurrence d'accès aux fichiers entre plusieurs machines. Cela permet de gÊrer les accès concurrentiels, la rÊpartition de charge sur plusieurs machines (deux dans notre cas) sera à gÊrer à part. C'est une approche intÊressante pour un petit cloud.

Ceph, à son niveau le plus bas, va stocker des objets (des couples de clÊ/valeur). Un cache d'abstraction nommÊe RBD (Rados Block Device) fournira un accès en mode bloc. Par-dessus cela, CephFS fournira une abstraction permettant l'accès en mode fichier.

1-1. NFS▲

NFS n'est pas en lui-mĂŞme un système de fichiers rĂŠpartis. Du point de vue utilisateur, vous pouvez le comparer Ă SMB : c'est un point d'exposition d'un système plus bas niveau pouvant lui ĂŞtre rĂŠparti. Pourquoi en parler ici alors ? Car certains systèmes de fichiers rĂŠpartis comme GlusterFS â que nous allons voir dans le prochain chapitre â implĂŠmentent directement un accès NFS.

NFS (Network file System) est un protocole historique de partage rĂŠseau sous Unix. Les anciennes versions n'ĂŠtaient pas sĂŠcurisĂŠes.

Sur les anciennes versions de NFS, avec un serveur NFS installÊ, pour partager un dossier, il suffisait d'ajouter une entrÊe dans le fichier /,etc/exports comme ceci :

/dossier_partage 192.168.1.0/24(rw)pour permettre Ă toutes les machines du rĂŠseau 192.168.1.0 de se connecter au partage en lecture/ĂŠcriture.

NFS fait un contrôle d'accès au niveau de l'hôte, pas du nom d'utilisateur.

L'accès client se fera soit par la commande mount, soit par une entrÊe dans le fichier /,etc/fstab comme ceci :

adresse_ip:/partage /point_de_montage nfs user,noauto 0 0La version 4 a crÊÊ une rÊelle rupture permettant :

- la sĂŠcurisation et le chiffrement des communications (support de Kerberos)Â ;

- dÊlÊgation de la gestion d'un document en local pour un client ;

- Migration possible d'une machine à l'autre du serveur de façon transparent pour le client.

Les systèmes Linux, Mac OS, Windows (seulement la version Pro, pour les versions home, il faut utiliser un logiciel externe) intègrent nativement un client NFS.

Mac OS, Linux, la plupart des NAS intègrent un serveur NFS (bien qu'en gÊnÊral on va plutôt utiliser un partage SMB). Windows Server intègre Êgalement un rôle serveur NFS.

VMWare permet de stocker ses machines virtuelles dans un partage NFS, ce sera par contre moins efficace qu'avec le filesystem VMFS natif, mais permettra par contre de facilement crĂŠer un stockage partagĂŠ.

Un volume GlusterFS, que nous verrons dans le prochain chapitre peut ĂŞtre montĂŠ en NFS.

1-2. GlusterFS▲

GlusterFS est un système de fichiers distribuĂŠ relativement souple. Il vient se greffer sur le système de fichiers local existant. Il permet de facilement ÂŤÂ concatĂŠner  plusieurs volumes locaux de plusieurs machines en un seul volume. Il possède plusieurs modes (distribuĂŠs ou non) de fonctionnement. Certains dâentre eux permettent la redondance. C'est un système relativement simple Ă mettre en place et efficace. Voici une explication des modes de fonctionnement.

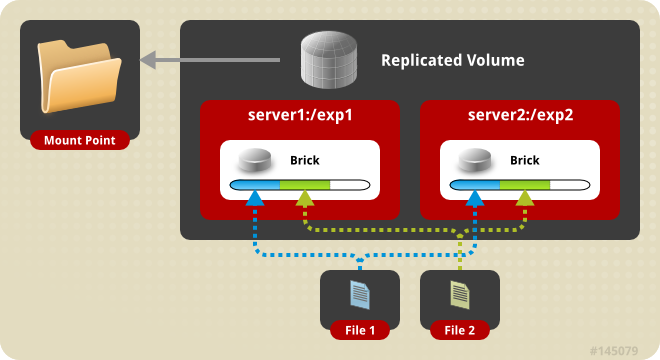

Mode rĂŠpliquĂŠ

Ce mode de fonctionnement rĂŠplique les fichiers sur les diffĂŠrents nĹuds du volume. Il s'agit lĂ uniquement de l'aspect redondance, les fichiers ne sont pas rĂŠpartis sur les diffĂŠrentes machines, ils sont rĂŠpliquĂŠs.

Mode distribuĂŠ

Dans ce mode, les fichiers sont rĂŠpartis entre les diffĂŠrentes machines du volume. Il n'y a pas de redondance. Vous devez donc vous assurer de la sauvegarde des donnĂŠes.

Mode distribuĂŠ-rĂŠpliquĂŠ

Ce mode cumule la rĂŠpartition et la redondance. Chaque nĹud du volume distribuĂŠ est redondĂŠ sur une autre machine. Il vous faut donc au minimum X machines multipliĂŠ par 2 pour un volume consistant, X reprĂŠsentant le nombre de nĹuds rĂŠpartis.

Autres modes possibles

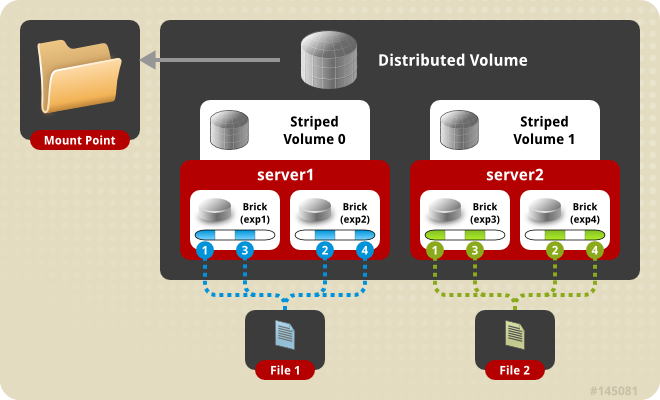

Volumes strippÊs : les fichiers sont ÊclatÊs en plusieurs morceaux, ceux-ci Êtant rÊpartis sur les machines membres du volume. Ce mode pourrait être comparÊ à du RAID 0 via le rÊseau.

Volumes strippÊs distribuÊs : les fichiers sont ÊclatÊs en plusieurs morceaux comme pour les volumes strippÊs, mais sont rÊpliquÊs sur plusieurs machines. Ce mode peut être comparÊ à du RAID 0+1 (encapsulation de RAID 0 dans un RAID 1) via le rÊseau.

Volumes dispersÊs : les fichiers sont morcelÊs sur plusieurs machines avec des fragments supplÊmentaires permettant la reconstruction de fichiers suite à une perte de fragments prÊsents sur une machine en panne. Ce fonctionnement est comparable à du RAID 5 via le rÊseau.

Volumes dispersÊs distribuÊs : il s'agit de volumes distribuÊs rÊpliquÊs utilisant des sous-volumes dispersÊs plutôt que rÊpliquÊs.

GlusterFS utilise la nomenclature suivante :

- pool de machines : machines qui sont appairÊes pour gÊrer un ou plusieurs volumes en commun ;

- brique : une brique est un point de stockage sur une machine d'un pool. Plusieurs briques font un volume.

1-2-1. Installation de GlusterFS▲

Pour crÊer un volume GlusterFS, il faut installer les paquets glusterfs-server et attr :

apt-get install glusterfs-server attrVotre système de fichiers doit supporter les attributs Êtendus. C'est le cas pour ext4.

1-2-2. Installation mode rĂŠpliquĂŠ▲

Une fois les paquets GlusterFS installĂŠs sur srv1, nous crĂŠons un dossier Ă la racine que nous nommons srv1_data et qui accueillera le point de partage.

Nous crĂŠons ensuite le volume que nous nommerons VOLÂ :

gluster volume create VOL srv1:/data_srv1 forceLa commande retourne lâindication suivante :

volume create: VOL: success: please start the volume to access dataOption force : GlusterFS exige ce paramètre au cas oÚ le point de montage utilisÊ pour le volume est dans la partition principale (ce que GlusterFS ne recommande pas).

La commande gluster volume list permet l'affichage des volumes visibles sur le système :

root@srv1:~# gluster volume list

VOL

root@srv1:~#Nous pouvons voir l'Êtat du volume avec la commande gluster volume info :

gluster volume info

Volume Name: VOL

Type: Distribute

Volume ID: 3fa199d1-7e7f-4ec5-985f-abf0f1f18ed4

Status: Created

Snapshot Count: 0

Number of Bricks: 1

Transport-type: tcp

Bricks:

Brick1: srv1:/data_srv1

Options Reconfigured:

transport.address-family: inet

performance.readdir-ahead: on

nfs.disable: onNous pouvons voir que le volume est en mode distribuĂŠ (distribute), avec une seule brique.

Une fois le volume crÊÊ, il nous faut l'activer :

root@srv1:~# gluster volume start VOL

volume start: VOL: success.Ă ce stade, le volume est montable, mais nous verrons cela dans le prochain chapitre.

Une fois les paquets installÊs sur srv2 et le dossier du point de montage crÊÊ, nous commençons par effectuer le jumelage GlusterFS de srv2 à srv1 depuis srv1 .

root@srv1:~# gluster peer probe srv2

peer probe : successLa commande suivante permet de voir les machines membres du pool :

root@srv1:~# gluster pool listEt qui donnera un rÊsultat comme ceci :

root@srv1:~# gluster pool list

UUID Hostname State

bca2bdf3-ec7e-4e26-8d5e-01584b09d604 srv2 Connected

ffaa8716-0a58-4cea-b01d-70f49bcbe998 localhost ConnectedLes fichiers /,etc/hosts de chaque machine doivent contenir les noms des nĹuds participant aux volumes GlusterFS.

La mĂŞme commande exĂŠcutĂŠe sur la seconde machine donnera le mĂŞme rĂŠsultat, les deux lignes seront juste interverties.

Nous ajoutons ensuite la brique de srv2 au volume :

gluster volume add-brick VOL replica 2 srv2:/data_srv2 force

volume add-brick: successNous affichons les informations du volume :

gluster volume info

Volume Name: VOL

Type: Replicate

Volume ID: 3fa199d1-7e7f-4ec5-985f-abf0f1f18ed4

Status: Started

Snapshot Count: 0

Number of Bricks: 1 x 2 = 2

Transport-type: tcp

Bricks:

Brick1: srv1:/data_srv1

Brick2: srv2:/data_srv2

Options Reconfigured:

nfs.disable: on

performance.readdir-ahead: on

transport.address-family: inetNous pouvons voir les deux briques et pouvons voir que le type de rÊplication est maintenant  replicate .

Nous aurions pu Êgalement crÊer le volume comme ceci à partir du moment oÚ Gluster Êtait installÊ sur les deux postes et les deux machines jumelÊes :

root@srv1:~# gluster create volume VOL replica 2 srv1:/data_srv1 srv2:/data_srv1 force

volume create: VOL; success: please start volume to access dataVoici le dÊtail des paramètres passÊs à la commande gluster create volume :

- VOLÂ : nom du volume crĂŠĂŠÂ ;Â

- replica : nombre de machines nĂŠcessaires au volume rĂŠpliquĂŠ (deux minimum) ;Â

- srv1:/data_srv1 : srv1 correspond au nom de la machine, /data_srv1 correspond au point de montage/dossier contenant les donnÊes du volume. Le nom de la machine et le chemin sont sÊparÊs par le caractère : ;

- srv2:/data_srv2: srv2 correspond au nom de la machine, /data_srv2 correspond au point de montage/dossier contenant les donnÊes du volume. Le nom de la machine et le chemin sont sÊparÊs par le caractère :.

Pour que la rĂŠplication fonctionne, il ne faut pas accĂŠder au contenu directement depuis les dossiers /data_srv1 ou /data_srv2 dans notre exemple, mais depuis un point de montage GlusterFS.

1-2-2-1. Montage d'un volume gluster▲

Pour monter un volume gluster, vous aurez besoin du paquet glusterfs-client. Si vous souhaitez monter un volume gluster sur une machine faisant office de serveur gluster, vous n'en aurez pas besoin, le paquet glusterfs-client ĂŠtant installĂŠ en mĂŞme temps que glusterfs-server.

Le montage sâeffectue de la mĂŞme façon que pour tout autre type de volume :

# mount -t glusterfs [nom d'hôte ou adresse IP]:/[nom du volume] [point de montage]Ou dans le /etc/fstab sur srv1 par exemple :

srv1:/VOL /mnt glusterfs defaults,_netdev 0 0Il est possible de monter un volume gluster via NFS. Cela n'est pas recommandÊ, car la sÊcuritÊ de NFS, notamment en troisième version est rudimentaire.

1-2-2-2. Ajout d'une machine supplĂŠmentaire au pool▲

Dans notre exemple, le serveur supplĂŠmentaire sera nommĂŠ srv3.

Lors de lâajout dâune machine au pool, il ne faut pas oublier dâajouter la nouvelle machine au fichier /,etc/hosts des machines dĂŠjĂ existantes ou s'assurer que l'entrĂŠe soit prĂŠsente dans les DNS utilisĂŠs.

La commande suivante ajoute srv3 au pool :

root@srv1:~#gluster peer probe srv3Nous ajoutons ensuite la nouvelle machine :

gluster volume add-brick VOL replica 3 srv3:/data_srv3 forceIl faut passer le bon nombre de machines Ă l'option replica.

Si nous appelons la commande gluster volume info, nous pouvons constater que le nombre de briques est passĂŠ de 1 x 2 = 2 Ă 1 x 3 = 3.

1-2-2-2-1. Mise Ă jour de srv3▲

Une fois la brique intÊgrÊe, aucune donnÊe n'est automatiquement rÊpliquÊe dessus. à ce stade, si nous ajoutons un nouveau fichier au volume, une copie sera bien prÊsente dans srv3, mais les anciens fichiers ne le seront pas. Pour pallier ceci, il faut lancer la commande suivante :

gluster volume heal VOL full1-2-2-3. Retrait d'une brique▲

Dans notre cas, nous allons retirer srv2 avec la commande suivante :

gluster volume remove-brick VOL replica 2 srv2:/data_srv2 forceLa commande demande confirmation avant de procĂŠder au retrait.

replica doit être Êgal au nombre final de briques après opÊration.

Dans notre cas oĂš les volumes sont rĂŠpliquĂŠs, il est possible de diminuer le nombre de volumes jusquâĂ nâen garder plus quâun. Le volume dans ce cas passera en mode distribuĂŠ.

Le retrait de la brique du volume ne supprime pas les donnĂŠes de celle-ci, mais il n'y a plus aucun lien entre celles-ci et le volume. Il ne sera pas possible de rĂŠintĂŠgrer la brique telle quelle.

Si vous souhaitez retirer la machine du pool :

gluster peer detach srv21-2-3. Test de mise en panne, simulation perte de srv1▲

L'arrêt de srv1 ne provoque aucune erreur. Comme nous avons appairÊ srv2 à srv1, nous pouvons voir l'Êtat de la connexion (et donc sa perte) avec la commande :

root@srv1:~# gluster peer status

Number of Peers: 1

Hostname: srv1

Uuid: c0c487b3-1135-41c7-b160-b8a061c10e9d

State: Peer in Cluster (Disconnected)Si vous souhaitez garder l'adresse IP de la machine perdue, la reconnexion est plus complexe.

1-2-3-1. Remplacement avec une nouvelle adresse IP▲

Nous appairons le nouveau serveur :

root@srv2:~# gluster peer probe srv1Nous remplaçons ensuite la brique :

root@srv2:~# gluster volume replace-brick VOL srv1:/data_srv1 [nouvelle ip/hote]/data commit forcePour que les machines se synchronisent, il faut ensuite lancer la commande :

gluster volume heal VOL full1-2-3-2. Remplacement en gardant la mĂŞme adresse IP▲

Il faut d'abord retirer la brique dÊfectueuse :

root@srv2:~# gluster volume remove-brick VOL srv1:/data_srv1 force

Removing brick(s) can result in data loss. Do you want to continue ? (y/n) y

volume remove brick commit force:successPuis :

root@srv2:~# gluster peer detach srv1

peer detach: successĂ ce stade, et comme dĂŠjĂ vu, le volume ne contenant plus qu'une seule brique, passe en mode distribuĂŠ.

Une fois le nouveau serveur prÊparÊ, nous le rÊappairons :

root@srv2:~# gluster peer probe srv1Nous ajoutons la nouvelle brique :

root@srv2:~# gluster volume add-brick VOL replica2 srv1:/data_srv1 forceNous resynchronisons le volume :

gluster volume heal VOL full

Launching heal operation to perform full self heal on volume VOL has been successful

Use heal info commands to check statusComme indiquÊ, nous pouvons voir le rÊsultat avec la commande :

gluster volume heal infoSi vous rencontrez des difficultĂŠs, consultez le chapitre 1.3.5.1Ajout dâune troisième machine pour la sauvegarde.

1-2-4. Installation en mode distribuĂŠ▲

Certaines notions sont identiques ou de simples variantes du mode rĂŠpliquĂŠ. Il est important pour la suite d'avoir lu le chapitre prĂŠcĂŠdent.

Nous prĂŠparons une machine srv1 qui contiendra le fichier fichier1.txt dans /data_srv1.

Nous y crĂŠons un volume avec une brique unique.

gluster volume create VOL srv1:/data_srv1 force

volume create: VOL: success: please start volume to access dataNous pouvons voir l'Êtat du volume avec la commande gluster volume info :

root@srv1:~# gluster volume info

Volume Name: VOL

Type: Distribute

Volume ID: 3f0a379a-921a-4c63-a5cc-7a62c3c39d19

Status: Created

Number of Bricks: 1

Transport-type: tcp

Bricks:

Brick1: srv1:/data_srv1Nous pouvons constater que le volume est en mode distribuĂŠ (distribute)

DÊmarrons ensuite le volume :

root@srv1:~# gluster volume start VOLNous prÊparons ensuite un serveur srv2 avec le fichier /data_srv2/fichier2.txt. Il nous faut appairer la nouvelle machine :

root@srv1:~# gluster peer probe srv2Puis ajouter la nouvelle brique :

root@srv1:~# gluster volume add-brick VOL srv2:/data_srv2

volume add-brick: successNous pouvons voir le nouvel Êtat du volume :

root@srv1:~# gluster volume info

Volume Name: VOL

Type: Distribute

Volume ID: 3f0a379a-921a-4c63-a5cc-7a62c3c39d19

Status: Started

Number of Bricks: 2

Transport-type: tcp

Bricks:

Brick1: srv1:/data_srv1

Brick2: srv2:/data_srv2Si nous montons le volume, nous pourrons voir les deux fichiers fichier1.txt et fichier2.txt. L'arrĂŞt d'une des deux machines fera disparaĂŽtre les fichiers prĂŠsents dans le nĹud coupĂŠ. Le premier accès sera lent, gluster cherchant la machine manquante. Le volume continue de fonctionner, il reste possible d'ajouter des fichiers. Le redĂŠmarrage de la machine manquante fera instantanĂŠment rĂŠapparaĂŽtre les fichiers inaccessibles.

CrĂŠez quelques fichiers pour tester le comportement. J'ai crĂŠĂŠ plusieurs fichiers nommĂŠs fichier3.txt, fichier4.txt, etc. Tous restant dans /data-srv1.

Gluster gère cela lui-même et du point de vue extÊrieur, cela n'a pas d'importance pour l'accès. Lisez cette partie de la documentation pour plus d'informations.

Il est possible de changer la rÊpartition avec la commande rebalance :

gluster volume rebalance VOL startSelon le volume de donnÊes à traiter, la rÊpartition peut prendre du temps. Il est possible de voir l'Êtat de celle-ci via la commande :

gluster volume rebalance VOL statusJ'ai pu constater que certains fichiers apparaissent en doublon dans les dossiers contenant les briques, ceux-ci restant uniques dans le point de montage GlusterFS. Je prĂŠsume que gluster est suffisamment intelligent pour les conserver tant qu'il y a de la place.

Rappel : si vous insĂŠrez un fichier dans un dossier faisant partie d'un volume gluster sans passer par le point de montage gluster, celui-ci nâapparaĂŽtra pas dans le volume et ne sera ni rĂŠpliquĂŠ, ni distribuĂŠ.

1-2-5. Test du mode distribuĂŠ-rĂŠpliquĂŠ▲

Pour ce mode, je vais repartir sur la configuration prÊcÊdente : deux machines en mode distribuÊ que je vais passer en mode distribuÊ-rÊpliquÊ.

Je vais rajouter deux machines supplÊmentaires aux deux machines dÊjà prÊsentes de façon à ce que chacune soit rÊpliquÊe.

Une fois les deux serveurs supplÊmentaires prÊparÊs et appairÊs, je les intègre au volume :

gluster peer probe srv3

gluster peer probe srv4gluster volume add-brick VOL replica 2 srv3:/data_srv3 srv4:/data_srv4 forceNous obtenons le rÊsultat suivant :

Volume Name: VOL

Type: Distributed-Replicate

Volume ID: 8f4d1305-7f28-41eb-bc76-85132c009c51

Status: Started

Number of Bricks: 2 x 2 = 4

Transport-type: tcp

Bricks:

Brick1: srv1:/data_srv1

Brick2: srv3:/data_srv3

Brick3: srv2:/data_srv2

Brick4: srv4:/data_srv4L'ajout d'un fichier dans le point de montage du volume GlusterFS, point de montage depuis srv1 et donc crĂŠation du fichier depuis srv1 va gĂŠnĂŠrer l'ajout de celui-ci dans /data_srv2 et /data_srv4. Nous avons donc bien la rĂŠplication ainsi que la distribution rĂŠpartie.

Seuls les nouveaux fichiers ou fichiers modifiÊs après l'ajout des briques bÊnÊficieront de la rÊplication.

Pour que tous les fichiers soient rĂŠpliquĂŠs, il faudra exĂŠcuter la commande rebalance comme vu prĂŠcĂŠdemment.

gluster volume rebalance VOL startLa rÊpartition devient donc :

- srv1 : fichier1.txt, fichier2.txt ;

- srv2 : fichier2.txt, fichier3.txt ;

- srv3 : fichier2.txt ;

- srv4 : fichier2.txt, fichier3.txt ;

Chaque fichier est donc bien rĂŠpliquĂŠ.

1-2-5-1. Simulation de perte de srv2▲

La manipulation la plus simple est de prĂŠparer une nouvelle machine, de lui affecter une nouvelle adresse IP, de l'appairer et d'utiliser replace-brick comme vu prĂŠcĂŠdemment.

Si vous souhaitez garder la mĂŞme IP, il va falloir effectuer plusieurs opĂŠrations.

La difficultĂŠ ici est qu'un nouveau serveur n'aura pas le mĂŞme UUID. Il y aura donc des manipulations supplĂŠmentaires Ă effectuer une fois le serveur prĂŠparĂŠ.

Il va nous falloir rĂŠcupĂŠrer l'ancien UUID de srv2Â :

root@srv1:~# grep -r uuid= /var/lib/glusterd/peers/* >fichier.txtUniquement valable si votre dossier ne contient qu'un seul fichier /var/lib/glusterd/peers/. Si ce n'est pas le cas, il faut identifier celui-ci et exÊcuter :

grep uuid= /var/lib/glusterd/peers/[nom du fichier contenant hostname=srv1] >fichier.txt

Nous transfÊrerons ensuite cet UUID sur le nouvel srv2. Nous insÊrons ensuite cet UUID dans /var/lib/glusterd/glustered :

cat fichier.txt >>/var/lib/glusterd/glusterd.infoNous Êditons le fichier afin de fixer l'UUID, puis redÊmarrons le service :

/etc/init.d/glusterfs-server restartNous appairons ensuite le serveur :

root@srv2:~# gluster peer probe srv1Nous redĂŠmarrons le service en appelant la commande gluster pool list, vous verrez les deux machines connectĂŠes.

Il faut ensuite synchroniser les volumes.

Depuis srv2, la commande gluster volume status vous retournera :

No volumes presentNous synchronisons les volumes avec la commande ;

root@srv1:~# gluster volume sync srv2 all

sync volume may data inaccessible while the sync is in progress. Do you want to continue ? (y/n)

volume sync success.Ă ce stade, les donnĂŠes ne sont pas encore synchronisĂŠes.

Mises Ă jour des mĂŠtadonnĂŠes

Il va nous falloir mettre Ă jour les mĂŠtadonnĂŠes sur le nouveau serveur depuis un serveur actif.

root@srv1:~# getfattr -n trusted.glusterfs.volume-id /data_srv1

getfattr:suppression des  / en tête des chemins absolus

# file: data_srv2/

trusted.glusterfs.volume-id=0s8VVsv3xRTa6G41mE+5E1dA==Il va falloir appliquer le volume id sur srv2 avec la commande :

setfattr -n trusted.glusterfs.volume-id -v '0s8VVsv3xRTa6G41mE+5E1dA==' /data_srv2Nous redÊmarrons ensuite le service et depuis srv1, nous exÊcutons :

gluster volume heal VOL full1-2-6. Sauvegarder/restaurer▲

Il me parait indispensable d'avoir une sauvegarde hors ligne mĂŞme en cas de système rĂŠpliquĂŠ, ceci afin de se protĂŠger de cryptolocker ou dâun effacement involontaire de fichiers. L'idĂŠal sera une sauvegarde en ligne sur la mĂŞme infrastructure, afin d'avoir une sauvegarde/restauration rĂŠgulière rapide, doublĂŠ par une sauvegarde hors ligne moins frĂŠquente.

1-2-7. SĂŠcuritĂŠ▲

Les serveurs faisant partie d'un pool gluster, ils se reconnaissent via leur UUID. Pour qu'un serveur fasse partie d'un pool, il doit ĂŞtre intĂŠgrĂŠ par un serveur du pool (c'est la commande gluster peer probe que nous avons dĂŠjĂ vue).

Par dÊfaut, n'importe quel client peut se connecter à un volume gluster. Il est possible de restreindre l'accès à certaines IP via la commande :

gluster volume set VOL auth.allow [adresse IP 1],[adresse IP 2]Par dĂŠfaut, le dialogue s'effectue en clair. Il est possible d'ĂŠtablir un dialogue SSL/TLS (documentation ici), celui-ci gĂŠrant l'authentification et le cryptage, mais pas l'autorisation. La sĂŠcurisation peut bien sĂťr se faire via un tunnel VPN, l'authentification et le cryptage ĂŠtant alors dĂŠlĂŠguĂŠ au tunnel VPN.

Comme il n'y a pas de login/mot de passe, il ne faut pas exposer directement un point de montage gluster aux utilisateurs. Par exemple, ce point de montage peut-ĂŞtre partagĂŠ en SMB. C'est le serveur SMB (point d'entrĂŠe exposĂŠ) qui sâoccupera alors des autorisations d'accès.

1-3. DRBD/OCFS2▲

Nous allons ici cumuler l'utilisation de DRBD avec OCFS, DRBD s'occupant de la rÊplication, OCFS de l'accès concurrentiel.

1-3-1. DRBD▲

1-3-1-1. Qu'est-ce que DRBDÂ ?▲

DRBDÂ : Distributed Replicated Block Device permet la rĂŠplication de pĂŠriphĂŠriques bloc entre serveurs via le rĂŠseau. Il peut ĂŞtre assimilĂŠ Ă du RAID 1 over IP.

Par dÊfaut, DRBD utilise la notion de primaire/secondaire. Un système de fichiers ne peut être montÊ que depuis une machine primaire. La machine primaire transmet les modifications à la machine secondaire. Une machine en mode secondaire ne peut pas être utilisÊe de façon à garder la cohÊrence du cache.

Nous utiliserons un mode permettant d'avoir deux machines primaires et donc pouvoir faire des lectures/ĂŠcritures depuis les deux nĹuds.

1-3-2. Installation de DRBD▲

La version utilisĂŠe ici sera la version 8.

L'installation se fait simplement par :

apt-get install drbd-utilsIl va falloir effectuer la configuration du nĹud primaire et du nĹud secondaire. Nous devons donc prĂŠparer un fichier de configuration en consĂŠquence.

DRBD va utiliser une partition en tant que pĂŠriphĂŠrique bloc sur chaque nĹud.

Une partition doit ĂŞtre mise Ă disposition. Utiliser une partition avec DRBD va ĂŠcraser son contenu.

Le fichier de configuration suivant, nommĂŠ r0.res et placĂŠ dans /,etc/drbd.d permet dâutiliser les nĹuds accessibles en 192.168.8.1 et 192.168.8.2. Sur chacun d'eux, nous utiliserons la partition /dev/sdb1. Ce fichier sera Ă adapter Ă votre cas.

resource r0 {

syncer {

rate 100M;

}

on srv1 {

device /dev/drbd0;

disk /dev/sdb1;

address 192.168.8.1:7789;

meta-disk internal;

}

on srv2 {

device /dev/drbd0;

disk /dev/sdb1;

address 192.168.8.2:7789;

meta-disk internal;

}

}Un fichier de dĂŠfinition de ressource DRBD doit avoir l'extension .res

Les noms de machines utilisÊs avec la directive  on 

doivent correspondre aux noms des machines retournĂŠs par la commande hostname.

Ce fichier devra ĂŞtre recopiĂŠ sur le second nĹud.

Le fichier est relativement simple Ă comprendre. Nous crĂŠons un volume DRBD accessible depuis /dev/drbd0 sur chaque nĹud.

Nous crĂŠons ensuite le volume sur le nĹud primaire :

# drbdadm create-md r0

initialising activiy log

NOT initialializing bitrmap

Writing meta data âŚ

New dbrd meta data block successfully created.Nous activons ensuite celui-ci :

# drbdadm up r0Nous pouvons observer le rÊsultat avec la commande drbd-overview :

# drbd-overview

0:r0/0 WFConnexion Secondary/Unknown Inconsistent/DUnknownIl faut effectuer ces commandes sur les deux nĹuds. Pour le second nĹud, la commande drbd-overview donne :

0:r0/0 Connected Secondary/Primary Inconsistent/ InconsistentNous voyons que la connexion est effectuĂŠe, mais que le ÂŤÂ RAIDÂ Âť DRBD est inconsistant.

Nous lançons ensuite la synchronisation uniquement depuis le poste maitre (192.168.8.1 ou srv1), nous passons ĂŠgalement le nĹud en primaire :

drbdadm -- --overwrite-data-of-peer primary r0Nous pouvons voir l'Êvolution de la synchronisation depuis le fichier /proc/drbd ou depuis la commande drbd-overview :

version: 8.4.3 (api:1/proto:86-101)

srcversion: 6681A7B41C129CD2CE0624F

0: cs:SyncSource ro:Primary/Secondary ds:UpToDate/Inconsistent C r-----

ns:417288 nr:0 dw:0 dr:418200 al:0 bm:25 lo:0 pe:0 ua:0 ap:0 ep:1 wo:f oos:7970004

[>...................] sync'ed: 5.1% (7780/8188)Mfinish: 0:05:05 speed: 26,080 (26,080) K/secUne fois la synchronisation terminĂŠe, nous allons passer le second nĹud en primaire. Pour cela, nous ajoutons les lignes suivantes dans le bloc ressources du fichier de configuration r0Â :

net {

allow-two-primaries;

after-sb-0pri discard-zero-changes;

after-sb-1pri discard-secondary;

}

startup {

become-primary-on both;

}Le fichier devient :

resource r0 {

syncer {

rate 100M;

}

net {

allow-two-primaries yes;

after-sb-0pri discard-zero-changes;

after-sb-1pri discard-secondary;

}

startup {

become-primary-on both;

}

on srv1 {

device /dev/drbd0;

disk /dev/sdb1;

address 192.168.8.1:7789:

meta-disk internal;

}

on srv2 {

device /dev/drbd0;

disk /dev/sdb1;

address 192.168.8.2:7789:

meta-disk internal;

}

}En dÊtails, voici les nouvelles fonctions utilisÊes :

- allow-two-primaries : permet d'utiliser deux nĹuds en mode primaire ;

- after-sb-0pri discard-zero-changes : en cas de split-brain, et que les deux nĹuds sont considĂŠrĂŠs comme primaires, DRBD va prendre les modifications les plus rĂŠcentes et les appliquer Ă l'autre nĹud ;

- after-sb-1pri discard-secondary : en cas de split-brain avec un nĹud primaire et un secondaire, le primaire ĂŠcrasera les modifications sur le secondaire ;

- after-sb-2pri disconnect (non utilisĂŠ) : en cas de split-brain, DRBD dĂŠconnecte les volumes et le rĂŠglage du problème (et la dĂŠcision du nĹud oĂš il faut sacrifier les diffĂŠrences) doit ĂŞtre fait manuellement.

Pensez à faire une copie du fichier de configuration avant modification pour pouvoir revenir à la situation initiale en cas de problème.

Nous recopions le fichier sur le second nĹud et redĂŠmarrons le service DRBD sur les deux machines.

Nous pouvons vÊrifier l'Êtat sur les deux serveurs avec :

# cat /proc/drbd

version: 8.4.3 (api:1/proto:86-101)

srcversion: 1A9F77B1CA5FF92235C2213

0: cs:Connected ro:Primary/Primary ds:UpToDate/Diskless C r-----

ns:912 nr:0 dw:0 dr:1824 al:0 bm:0 lo:0 pe:0 ua:0 ap:0 ep:1 wo:f oos:8387292Rappel : Il n'est pas possible de monter un système de fichiers dans un volume DRBD en mode secondaire.

1-3-2-1. SĂŠcuritĂŠ de DRBD▲

Il est possible de sÊcuriser les dialogues DRBD en ajoutant les ÊlÊments suivant dans le fichier de configuration :

net {

cram-hmac-alg "sha1";

secret "le mot de passe";

}Un transfert via une connexion sĂŠcurisĂŠe entre les nĹuds hors DRBD peut aussi ĂŞtre utilisĂŠ. (interconnexion via cartes rĂŠseau dĂŠdiĂŠes hors rĂŠseau normal, VPN).

1-3-2-2. Surveillance des volumes DRBD▲

DRBD est fourni avec un système de handlers et des scripts pour gĂŠrer les problèmes. Par exemple, la mise en place dâune notification par mail lors dâun split-brain sâeffectue en ajoutant ce qui suit dans la section resources :

handlers {

split-brain "/usr/lib/drbd/notify-split-brain.sh <adresse>";

...

}Je vous invite Ă regarder les diffĂŠrents scripts Ă disposition dans /usr/lib/drbd.

1-3-2-3. Tests▲

Une fois la synchronisation effectuÊe, nous crÊons ensuite un système de fichiers sur /dev/drbd0 :

mkfs.ext4 /dev/drbd0Quelle que soit la machine, le système de fichiers sera prÊsent sur l'autre, le volume DRBD Êtant rÊpliquÊ.

Nous y crÊons un fichier de test fichier1.txt après montage du volume DRBD dans un point de montage.

Nous montons ensuite /dev/drbd0 sur la seconde machine (srv2), nous voyons bien le fichier fichier1.txt.

Nous ajoutons un fichier fichier2.txt depuis srv2, celui-ci nâapparaĂŽt pas sur srv1.

Nous dÊmontons et remontons le volume sur srv1, Après remontage, nous voyons bien le second fichier.

Explications

DRBD travaille au niveau bloc et non au niveau du système de fichiers. Nous pouvons l'utiliser tel quel en tant que sauvegarde, mais pas pour un double montage. Le monter simultanÊment risque de provoquer une inconsistance au niveau du système de fichiers.

Pour pallier ceci, nous allons utiliser OCFS2, un système de fichiers permettant les accès concurrents.

1-3-3. OCFS2▲

1-3-3-1. Qu'est-ce qu'OCFS2Â ?▲

OCFS2 (Oracle Cluster File System) est un système de fichiers sous licence GPL qui permet l'accès concurrent Ă des fichiers, c'est-Ă -dire un accès simultanĂŠ possible en lecture/ĂŠcriture Ă un fichier sans risque dâinconsistance. Ceci nous permettra de rĂŠsoudre le problème vu dans le chapitre prĂŠcĂŠdent.

1-3-3-2. Installation et paramĂŠtrage d'OCFS2▲

Pour installer OCFS2, il faut installer le paquet comme ci-dessous :

apt-get install ocfs2-toolsNous crÊons le système de fichiers ocfs sur le volume DRBD :

mkfs -t ocfs2 -L MYCLOUD /dev/drbd0Avec en options :

- -LÂ : le nom du volume OCFS2.

La configuration s'effectue via les commandes suivantes.

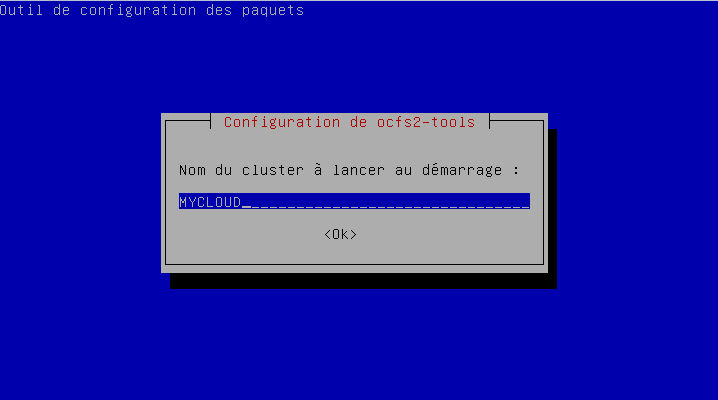

CrÊation du cluster que nous nommerons  MYCLOUD  :

o2cb add-cluster MYCLOUDAjout des nĹuds :

o2cb add-node MYCLOUD --ip 192.168.8.1 --port 7777 --number 0 srv1

o2cb add-node MYCLOUD --ip 192.168.8.2 --port 7777 --number 1 srv2Ce qui nous donnera La configuration suivante dans le fichier /etc/ocfs2/cluster.conf :

cluster:

heartbeat_mode = local

node_count = 2

name = MYCLOUD

node:

number = 0

cluster = MYCLOUD

ip_port = 7777

ip_address = 192.168.8.1

name = srv1

node:

number = 1

cluster = MYCLOUD

ip_port = 7777

ip_address = 192.168.8.2

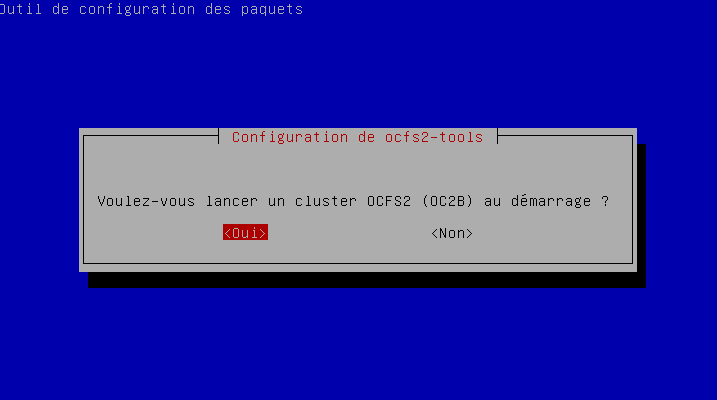

name = srv2Afin de modifier la configuration au dÊmarrage, nous lançons :

dpkg-reconfigure ocfs2-toolsAprès un redÊmarrage de la machine, ou plus simplement des services o2cb et ocfs2, il suffit de monter le volume :

mount -t ocfs2 /dev/drbd0 /dataou grâce au fichier fstab :

/dev/drbd0 /data ocfs2 _netdev 0 0Pour avoir accès aux donnÊes sur la seconde machine, il faudra effectuer les mêmes opÊrations après voir copiÊ le fichier de configuration /etc/ocfs2/cluster.conf.

Les tests depuis les deux postes sont fonctionnels. Le fichier fichier1.txt crĂŠĂŠ depuis srv1 est visible sur srv2, et le fichier fichier2.txt crĂŠĂŠ depuis srv2 est visible dans le dossier /data de srv1.

Le montage automatique au redÊmarrage ne semble pas fonctionnel. Peut-être un problème de configuration.

1-3-4. Couplage DRBD/OCFS2Â : Simulation de panne▲

Pour simuler notre panne, nous allons arrĂŞter srv2. Après quelques secondes, lâerreur suivante apparaĂŽt sur la console de srv1 :

drbd r0: PingAck did not arrive in timeDe plus, la commande drbd-overview retournera un message similaire Ă Â :

0:r0/0 WFConnection Primary/Unknown UpToDate/DUnknown /data ocfs2 8.0G 151M 7.9G 2%Le premier accès à la commande drbd-overview va être long.

L'arrĂŞt de srv2 ne perturbe pas le volume /data dans srv1, sauf si celui-ci est redĂŠmarrĂŠ.

Au redÊmarrage de srv2, j'ai le message suivant dans la console :

A start job is running for dev-drbd0.device (36s/1mn 30s)Comme nous l'avons dÊjà vu, nous ne pouvons pas monter un volume DRBD en mode Secondary. Le volume OCFS2 n'est pas montable. Une tentative de montage avec mount -a donnera le message suivant :

mount.ocfs2: Device name specified was not found while opening device /dev/drbd0Une fois le système dÊmarrÊ, le volume n'est pas disponible. En exÊcutant la commande drbd-overview, nous pouvons voir :

0:r0/0 Unconfigured . .La commande :

drbdadm up r0Nous retournera :

Marked additional 12 MB as out-of-sync based on AL.Et le rappel de drbd-overview nous donnera :

0:r0/0 Connected Secondary/Primary UpToDate/UpToDateJe redĂŠmarre DRBD sur les deux postes avec la commande service drbd restart.

Les deux postes repassent en mode Primary.

Il est alors possible de remonter le volume OCFS2 sur srv2 avec la commande mount -a (et sur srv1).

Nous avons donc une mĂŠthode pour redĂŠmarrer en mode dĂŠgradĂŠ.

1-3-5. Couplage DRBD/OCFS2Â : redĂŠmarrage des deux serveurs▲

Le redÊmarrage des deux serveurs simultanÊment nous donnera une situation de split-brain. La commande drbd-overview nous donnera  Unconfigured  sur les deux postes.

Pour avoir accès au volume sur un des postes, il faudra lancer les commandes suivantes :

- drbdadm up r0Â ;

- drbdadm primary r0Â ;

-

mount -a.

Sur le second poste :

- drbdadm up r0.

Ă ce stade, le volume DRBD sera consistant avec le mode Primary sur le premier poste, et le mode Secondary sur le second. Un mount -a sur le second nĹud rĂŠactivera le volume OCFS2.

En cas de perte complète d'un nĹud (et non plus un simple arrĂŞt), le volume sera indisponible sur le second nĹud tant que la synchronisation n'a pas ĂŠtĂŠ refaite. Une fois celle-ci refaite, il sera possible de passer le nĹud en Primary et ensuite de monter le volume OCFS2.

1-3-5-1. Ajout dâune troisième machine pour la sauvegarde▲

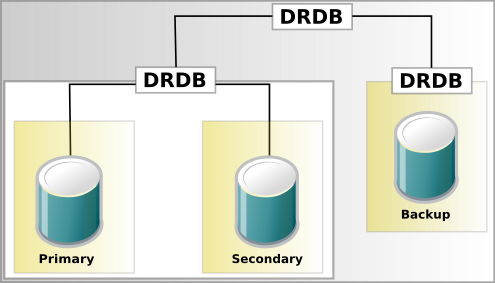

La version 9 de DRBD permet dâavoir jusqu'Ă 16 machines. Ce chapitre repose sur la version 8.4 et permet d'empiler deux volumes DRBD. Ce système est appelĂŠ stacked et correspond Ă cette architecture :

|

|

Nous allons donc mettre en place un serveur srv3 comme serveur de sauvegarde.

Nous ajoutons la nouvelle ressource imbriquÊe dans /etc/drbd.d/r0.res à la suite de r0 :

resource r1 {

stacked-on-top-of r0 {

device /dev/drbd10;

address 192.168.8.4:7788;

}

on srv3 {

device /dev/drbd10;

disk /dev/sdb1;

address 192.168.1.3:7788;

meta-disk internal;

}

}Vous remarquerez que nous utilisons un port diffĂŠrent, chaque ressource dialoguant sur son propre port.

Nous dĂŠmontons ensuite le volume sur les deux machines. La commande drbd-overview vous permet de voir si le volume est montĂŠÂ :

0:0/r0 Connected Primary/Primary UpToDate/ UpToDate /data ocfs2 63M 13m 51m 20%

10:r1/0 ^^0 Unconfigured .Voici le retour lorsque le volume est dĂŠmontĂŠÂ :

0:0/r0 Connected Primary/Primary UpToDate/ UpToDate 11-dev of: 10 r1/0

10:r1/0 ^^0 Unconfigured .Nous pouvons voir que le volume r1 n'est pas configurĂŠ.

Pour cela il nous faut exÊcuter les commandes :

drbdadm --stacked create-md r1

md_offset 66015232

al_offset 65982464

bm_offset 65978368

Found some data

==> This might destroy existing data! <==

Do you want to proceeed?

[need to type 'yes' to confirm]Il faudra confirmer en tapant  yes , puis vous aurez un message de ce type en retour :

Initializing activity log

NOT initializing bitmap

Writing meta data...

New drbd meta data block successfull created.Nous tapons ensuite la commande :

drbdadm --stacked up r1à ce stade, il n'est pas possible de monter le volume.

Comme prĂŠcisĂŠ par le message lors de la commande, effectuer ceci sur un volume existant peut provoquer une perte de donnĂŠes.

Nous copions ensuite la configuration sur srv3, puis crÊons le volume DRBD dessus :

root@srv3:~# drbdadm create-md r1

initializing activity log

NOT initializing bitmap

Writing meta data...

New drbd meta data block successfully created.Puis :

drbdadm up r1Nous invalidons ensuite le contenu de la machine par :

drbdadm invalidate r1La synchronisation de srv3 se dĂŠclenche immĂŠdiatement.

Nous activons le mode primaire sur srv1Â :

root@srv3:~# drbdadm âstacked primary r1il faut ensuite monter le volume avec /dev/drbd10 au lieu de /dev/drbd0.

/dev/drbd10 sera le nom de device utilisĂŠ pour un volume stacked.

En cas de perte d'une des machines, il faudra appliquer la mĂŠthode vue au chapitre 1.3.5.1Ajout dâune troisième machine pour la sauvegarde.

1-3-5-2. Perte de liaison entre deux machines : split-brain▲

Si les deux machines croient que l'autre ne fonctionne plus, vous vous trouverez dans une situation nommÊe split brain. Dans cette situation, les deux machines passeront en mode standalone avec le statut inconnu :

0:r0/0 StandAlone Primary/Unknown /data ocfs2 127M 17M 1111M 14%Pour rÊgler ce problème, vous devrez en considÊrer une comme  sacrifiable  et la resynchroniser entièrement à partir de l'autre. Si la situation a perdurÊ un moment, et qu'il y a des diffÊrences entre les deux, les diffÊrences de la machine sacrifiÊe seront perdues.

Nous commençons par effectuer un redÊmarrage des deux machines. à ce stade aucune des deux ne devrait être connectÊe au volume OCFS2.

Vous pouvez voir un peu plus haut que la commande drbd-overview indique des informations sur le volume montĂŠ.

Nous pouvons voir que le volume est montĂŠ dans /data. Si aucun volume n'est montĂŠ, vous ne verrez que l'information Primary/Unknown (ou Secundary/Unknown).

Nous allons basculer la machine  victime  en secondaire si nÊcessaire.

Avant ce redĂŠmarrage, nous commentons dans le fichier /etc/drbd.d/r0 les lignes concernant la gestion du double primaire.

Après redÊmarrage. Avec drbd-overview, vous devriez avoir quelque chose comme :

0:r0/0 WFConnection Secondary/Unknown UpToDate/UnknownNous allons ensuite dÊclarer une des machines comme obsolète, commande à effectuer sur la machine concernÊe :

drbdadm â --discard-my-data connect r0La resynchronisation se dĂŠclenche. Pendant celle-ci, vous pouvez basculer la machine servant de source en primaire et remonter le volume OCFS.

Une fois la synchronisation terminĂŠe, nous dĂŠcommentons les lignes concernant l'utilisation de deux machines primaires et redĂŠmarrons le service sur les machines une Ă une.

1-3-6. DRBD 9▲

DRBD 9 permet d'utiliser LVM comme conteneur de volume. Il permet aussi d'avoir jusqu'Ă 16 nĹuds par ressource sans devoir recourir Ă l'empilement comme vu avec la version 8.4. La version fournie avec Debian 9 ĂŠtant la 8,4, il va falloir compiler :

- le module noyau ;

- les outils drbd (drbd-utils).

Avant de commencer, nous installerons LVM (apt-get install lvm2).

1-3-6-1. Installation du module noyau :▲

Commençons par tÊlÊcharger les sources du module :

wget https://www.linbit.com/downloads/drbd/9.0/drbd-9.0.19-1.tar.gzJe n'ai pas pris la dernière version pour des questions de soucis de compilation sur Debian 9 utilisÊ (Debian 9 Êtant une ancienne version maintenant).

Les liens de tĂŠlĂŠchargements peuvent changer avec le temps et devront donc ĂŞtre adaptĂŠs

DÊcompression :

gunzip drbd-9.0.19-1.tar.gzDÊsarchivage :

tar -xvf drbd-9.0.19-1.tarLa compilation se fera avec la commande make dans le dossier dĂŠcompressĂŠ. Les prĂŠrequis sont make bien sĂťr, et les en-tĂŞtes de votre noyau (installable avec la commande apt-get install linux-headers-$(uname -r)).

Une fois la compilation effectuÊe, l'installation se fera par :

make install1-3-6-2. Installation des outils ▲

wget https://www.linbit.com/downloads/drbd/utils/drbd-utils-9.13.1.tar.gz

gunzip drbd-utils-9.13.1.tar.gz

tar -xvf drbd-utils-9.13.1.tarLes prÊrequis avant compilation seront gcc, flex, xlstproc (pour la documentation). La compilation se fera ensuite par :

./configure

makeà la fin de la compilation, j'ai eu le message d'erreur suivant :

Makefile:108 : la recette pour la cible ÂŤÂ doc  a ĂŠchouĂŠCela nâempĂŞche pas le make install.

Nous faisons ensuite l'installation :

make install1-3-6-3. PrĂŠparation du volume LVM▲

Nous commençons par prÊparer la partition à l'usage de LVM (dans notre cas sdb1) :

pvcreate /dev/sdb1Nous crĂŠons ensuite un volume Group que nous appellerons vg01Â :

vgcreate vg01 /dev/sdb1Et crĂŠons enfin le volume logique lv01 (volume de 1900Â Mo sur un disque de 2Â Go pour l'essai)Â :

lvcreate -L 1900 -n lv01 vg01Nous crÊons ensuite un fichier de configuration dans un premier temps avec une machine unique :

resource r0 {

protocol C;

on srv1 {

disk /dev/vg01/lv01;

device /dev/drbd0;

address 192.168.1.201:7789;

meta-disk internal;

node-id 0;

}

}Comme nous utilisons une version compilĂŠe de DRBD, les fichiers de configuration devront ĂŞtre placĂŠs dans /usr/local/,etc/drbd.d au lieu de /,etc/drbd.d.

Remarquez la prĂŠsence de l'option node-id 0;. Cette option, apparue avec DRBD 9 permet de numĂŠroter chaque nĹud participant au cluster.

La procĂŠdure sera ensuite la mĂŞme que pour la version 8.4.

CrÊation des mÊtadonnÊes sur le volume :

drbdadm create-md r0Activation du volume :

drbdadm up r0à ce stade, nous pouvons voir l'Êtat du volume avec la commande drbdadm status, qui remplace drbd-overview :

~# drbdadm status

r0 role:Secondary

disk:InconsistentNous allons ensuite passer celui-ci en primaire. La syntaxe a ÊtÊ simplifiÊe par rapport aux versions prÊcÊdentes :

drbdadm primary r0 --forceRÊsultat de drbdadm status :

# drbdadm status

r0 role:Primary

disk:UpToDateNous modifions le fichier de configuration pour intÊgrer la seconde machine :

resource r0 {

protocol C;

on srv1 {

disk /dev/vg01/lv01;

device /dev/drbd0;

address 192.168.1.201:7789;

meta-disk internal;

node-id 0;

}

on srv2 {

disk /dev/vg01/lv01;

device /dev/drbd0;

address 192.168.1.202:7789;

meta-disk internal;

node-id 1;

}

}Rappel : la valeur node-id doit ĂŞtre unique Ă chaque nĹud.

Une fois le fichier mis à jour, la commande suivante permet de prendre en compte les changements :

drbdadm adjust r0La commande drbdadm status nous montre l'attente de connexion pour srv2 non encore prĂŠparĂŠ.

~# drbdadm status

r0 role:Primary

disk:UpToDate

srv2 connection:ConnectingReste Ă prĂŠparer srv2. La copie des dossiers source depuis srv1 permettra d'installer le module noyau DRBD avec make install sans devoir recompiler (le module .ko compilĂŠ sur srv1 ĂŠtant dans le dossier des sources copiĂŠ). Pour les outils, il faudra rĂŠexecuter ./configure, puis make et make install. Restera Ă copier le fichier de configuration.

Une fois le volume LVM crÊÊ, les mÊtadonnÊes DRBD crÊÊes (avec drbdadm create-md r0), le lancement de la commande drbdadm up r0 dÊclenchera la synchronisation. Ci-dessous la synchronisation en cours :

~# drbdadm status

r0 role:Primary

disk:UpToDate

srv2 role:Secondary

replication:SyncSource peer-disk:Inconsistent done:43.03Une fois les volumes synchronisĂŠs, passer srv2 en primaire ne posera pas de difficultĂŠs.

1-3-6-4. IntĂŠgration troisième poste▲

Bien que cela soit possible, je n'ai pas rÊussi à intÊgrer un troisième poste sans erreur. La documentation manque de prÊcision.

1-3-6-5. drbdmanage▲

drbdmanage est un utilitaire simplifiant la gestion de DRBD. drbdmanage est dĂŠprĂŠciĂŠ et remplacĂŠ par linstor. Celui-ci ĂŠtant toujours disponible sur github, j'ai dĂŠcidĂŠ d'en faire une prĂŠsentation.

Nous commençons par rÊcupÊrer les sources :

git clone https://github.com/LINBIT/drbdmanage.gitPrÊrequis : python-dbus, python-gobject.

Une fois entre dans le dossier, l'installation se fera par :

./setup.py installLa commande drbdmanage sera alors disponible.

drbdmanage attend par dĂŠfaut la prĂŠsence d'un volume group LVM nommĂŠ drbdpool. Si vous souhaitez dĂŠfinir un nom diffĂŠrent dĂŠcommentez la ligne drbdctrl-vg dans le fichier /etc/drbdmanage.cfg et mettez-y la valeur de notre choix, dans l'exemple suivant le volume group utilisĂŠ sâappellera ÂŤÂ drbd , crĂŠĂŠe dans la partition /dev/sdb1 comme ceci :

~# pvcreate /dev/sdb1

Physical volume "/dev/sdb1" successfully created.

~# vgcreate drbd /dev/sdb1

Volume group "/dev/sdb1" successfully created.Avant de crÊer le cluster, comme drbdmanage a ÊtÊ installÊ par les sources, pour Êviter un message d'erreur dbus, il faut crÊer le lien symbolique suivant :

ln -s /usr/local/bin/dbus-drbdmanage-service /usr/binCes opĂŠrations prĂŠliminaires seront Ă effectuer sur les deux machines minimales qui seront mises en place.

Nous crÊons une liaison SSH par clÊ entre les deux serveurs :

root@srv1 ~# ssh-keygen -t rsa

Generating public/private rsa key pair.

Enter file in which to save the key (/home/cloud/.ssh/id_rsa):

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /home/cloud/.ssh/id_rsa.

Your public key has been saved in /home/cloud/.ssh/id_rsa.pub.

The key fingerprint is:

SHA256:RgvrHWfPnz6PiniTRaTL0AFHFoR6xWp/cRZb6Q1RJc8 cloud@Debian

The key's randomart image is:

+---[RSA 2048]----+

| .**. oo=|

| .o+ . o=.|

| ...+ + .=E|

| .+=.o o +..|

| .oS+oo + |

| . o ++oo |

| . . +o |

| .+. ..o |

| .....o=o.|

+----[SHA256]-----+

root@srv1 ~# ssh-copy-id root@192.168.1.202

/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/cloud/.ssh/id_rsa.pub"

The authenticity of host 'srv1 (192.168.1.201)' can't be established.

ECDSA key fingerprint is SHA256:LLALxAyQlZLXlVtPSyTrOkUaTKKC+C0UCDAQKrWTuMI.

Are you sure you want to continue connecting (yes/no)? yes

/usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed

/usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys

root@srv1's password:

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'cloud@srv1.local'"

and check to make sure that only the key(s) you wanted were added.Nous initialisons ensuite le cluster :

drbdmanage init 192.168.1.201Qui nous retournera :

You are going to initialize a new drbdmanage cluster.

CAUTION! Note that:

* Any previous drbdmanage cluster information may be removed

* Any remaining resources managed by a previous drbdmanage installation

that still exist on this system will no longer be managed by drbdmanage

Confirm:

yes/no: yes

Empty drbdmanage control volume initialized on '/dev/drbd0'.

Empty drbdmanage control volume initialized on '/dev/drbd1'.

Waiting for server: .

Operation completed successfullyNous pouvons voir la liste des nĹuds (un seul pour le moment) avec la commande :

drbdmanage list-nodesQui nous retournera :

+------------------------------------------------------------------------------+

| Name | Pool Size | Pool Free | | State |

|------------------------------------------------------------------------------|

| srv1 | 2044 | 2036 | | ok |

+------------------------------------------------------------------------------+Nous ajoutons ensuite le second nĹud :

drbdmanage add-node srv2 192.168.1.202

Operation completed successfully

Operation completed successfully

Executing join command using ssh.

IMPORTANT: The output you see comes from srv2

IMPORTANT: Your input is executed on srv2

You are going to join an existing drbdmanage cluster.

CAUTION! Note that:

* Any previous drbdmanage cluster information may be removed

* Any remaining resources managed by a previous drbdmanage installation

that still exist on this system will no longer be managed by drbdmanage

Confirm:

yes/no: yes

Waiting for server to start up (can take up to 1 min)

Waiting for server: ........

Operation completed successfully

Give leader time to contact the new node

Operation completed successfully

Operation completed successfullyLa commande drbdmanage list-nodes nous retournera ceci :

drbdmanage list-nodes

+------------------------------------------------------------------------------+

| Name | Pool Size | Pool Free | | State |

|------------------------------------------------------------------------------|

| srv1 | 2044 | 2036 | | online/quorum vote ignored |

| srv2 | 2044 | 2036 | | offline/quorum vote ignored |

+------------------------------------------------------------------------------+Nous crÊons ensuite une ressource :

:~/drbdmanage# drbdmanage add-resource r0

Operation completed successfullyPuis un volume dans la ressource :

:~/drbdmanage# drbdmanage add-volume r0 1500MB

Operation completed successfullyNous pouvons ensuite voir la liste des volumes avec la commande drbdmanage list-volumes :

~# drbdmanage list-volumes

+------------------------------------------------------------------------------+

| Name | Vol ID | Size | Minor | | State |

|------------------------------------------------------------------------------|

| r0 | 0 | 1,40 GiB | 100 | | ok |

+------------------------------------------------------------------------------+Nous pouvons voir la valeur 100 au niveau du minor, ce qui signifie que le nom du device Ă utiliser sera /dev/drbd100.

Nous le formatons en OCFS2 comme vu au chapitre prÊcÊdent :

~# mkfs -t ocfs2 -L MYCLOUD /dev/drbd100

mkfs.ocfs2 1.8.4

Cluster stack: classic o2cb

Label: MYCLOUD

Features: sparse extended-slotmap backup-super unwritten inline-data strict-journal-super xattr indexed-dirs refcount discontig-bg

Block size: 4096 (12 bits)

Cluster size: 4096 (12 bits)

Volume size: 1500000256 (366211 clusters) (366211 blocks)

Cluster groups: 12 (tail covers 11395 clusters, rest cover 32256 clusters)

Extent allocator size: 4194304 (1 groups)

Journal size: 67108864

Node slots: 2

Creating bitmaps: done

Initializing superblock: done

Writing system files: done

Writing superblock: done

Writing backup superblock: 1 block(s)

Formatting Journals: done

Growing extent allocator: done

Formatting slot map: done

Formatting quota files: done

Writing lost+found: done

mkfs.ocfs2 successful1-3-6-6. Linstor▲

Linstor est le successeur de DRBD. Il est utilisĂŠ dans les solutions comme OpenNebula et Proxmox. Celui-ci est libre.

N'ayant pas rĂŠussi Ă l'installer, je n'ai pu le tester.

1-4. Ceph▲

Ceph est une plateforme libre de stockage distribuÊ. Ceph est conçu pour être automatiquement distribuÊ et rÊparable et sans point unique de dÊfaillance.

Ceph est utilisable en mode bloc ou en mode objet (comme Amazon S3 en mode HTTP REST).

Ceph pourrait Ă lui tout seul faire l'objet d'un tutoriel, nous allons ici le survoler. Vous pourrez avoir une installation fonctionnelle au moins Ă minima en suivant ce chapitre.

1-4-1. Modules Ceph▲

Ceph est composĂŠ de plusieurs dĂŠmons, rĂŠpartis sur plusieurs machines. Il est possible d'avoir plusieurs types de dĂŠmons sur la mĂŞme machine, mais cela n'a pas dâintĂŠrĂŞt et est mĂŞme contre-productif sur un important cluster.

- Monitor (Mon) : ce sont les chefs dâorchestre du cluster Ceph. S'il n'y a pas de moniteur disponible, il n'y a pas dâaccès au cluster Ceph. Pour assurer la pĂŠrennitĂŠ du cluster, les moniteurs doivent ĂŞtre sur des machines indĂŠpendantes et en nombre impair. Un minimum de trois moniteurs est recommandĂŠ.

- OSD (Object Storage Device ou OSD)Â : il y a un dĂŠmon OSD par device OSD. Ce dĂŠmon est en charge du stockage, de la rĂŠplication et de la redistribution des donnĂŠes en cas de dĂŠfaillance. Il fournit les informations de monitoring aux monitors. Un device OSD est l'unitĂŠ bas niveau de stockage des donnĂŠes. Un cluster Ceph va ĂŞtre composĂŠ d'un ensemble d'OSD.

- Meta Data Service (MDS)Â : nĂŠcessaire Ă lâutilisation de CephFS, va stocker les mĂŠtadonnĂŠes de tous les fichiers et permettre le support de POSIX.

- CephFS : système de fichiers POSIX fourni avec Ceph et sâappuyant sur le stockage Ceph (objet ou bloc). Câest la couche de plus haut niveau.

Les dÊmons MDS et CephFS ne sont nÊcessaires que si vous utilisez Ceph avec son système de fichiers intÊgrÊ.

ĂlĂŠments un peu plus avancĂŠs

- pool : regroupement logique de stockage dâobjets. Des pools par dĂŠfaut suffisent Ă la gestion dâun petit cluster Ceph, mais pour des clusters intersites, il est important dâaffiner ce type de rĂŠglage. Exemple : nombre de copies/rĂŠpliquas des objets, rĂŠpartition des donnĂŠes de type RAID5, etc.

- Placement Group (PG)Â : peut ĂŞtre vu comme des unitĂŠs dâallocation et/ou index internes, ils servent Ă la rĂŠpartition dans le cluster. Plus il y a de PG, plus on consomme de ressources (CPU/RAM).

Il est possible dâaugmenter le nombre de PG dâun pool, mais pas de le rĂŠduire.

1-4-2. Fonctionnement de Ceph▲

CRUSH

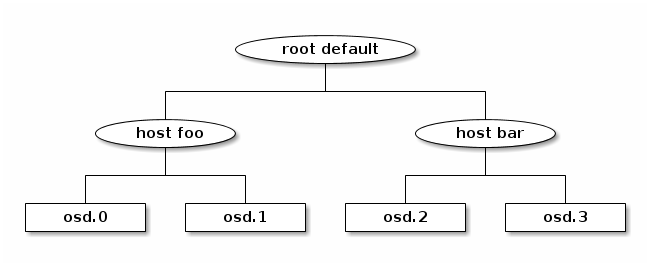

CRUSH est lâalgorithme de rĂŠpartition des donnĂŠes dans le cluster. La crush map est la cartographie de la rĂŠpartition des donnĂŠes. Les crush rules sont les règles de rĂŠpartition des donnĂŠes.

Quand vous crĂŠez un cluster Ceph, il y a une crush map par dĂŠfaut qui peut fonctionner automatiquement. Mais pour un gros cluster, il est important de la gĂŠrer. Cela permet dâaffiner la rĂŠpartition des donnĂŠes (entre deux centres de donnĂŠes par exemple), et de repĂŠrer facilement un OSD tombĂŠ (dans quel centre de donnĂŠes, quelle baie, quelle machine, etc.).

Voici les diffÊrents niveaux utilisÊs par les crush map :

- OSD (peut être vu comme le  device ) ;

- host ;

- chassis ;

- rack ;

- row ;

- pdu ;

- pod ;

- room ;

- datacenter ;

- region ;

- root.

SchÊma tirÊ de la documentation officielle :

Voici le processus de lecture/Êcriture sur un cluster Ceph :

- Le client Ceph contacte un moniteur pour obtenir la cartographie du cluster ;

- Les donnĂŠes sont converties en objets (contenant un identifiant dâobjet et de pool)Â ;

- Lâalgorithme CRUSH dĂŠtermine le groupe oĂš placer les donnĂŠes et lâOSD primaire ;

- Le client contacte lâOSD primaire pour stocker/rĂŠcupĂŠrer les donnĂŠes ;

-

LâOSD primaire effectue une recherche CRUSH pour dĂŠterminer le groupe de placement et lâOSD secondaire.

- Dans un pool rĂŠpliquĂŠ, lâOSD primaire copie lâobjet vers lâOSD secondaire,

- Dans un pool avec erasure coding, lâOSD primaire dĂŠcoupe lâobjet en segments, gĂŠnère les segments contenant les calculs de paritĂŠ et distribue lâensemble de ces segments vers les OSD secondaires tout en ĂŠcrivant un segment en local.

1-4-3. Installation de Ceph▲

Nous utiliserons la version Ceph Luminous (v,12).

1-4-3-1. Installation d'une première machine▲

1-4-3-1-1. PrĂŠparations▲

Nous allons commencer par les prĂŠrequis.

Nous fixons le nom de notre hôte dans le fichier /,etc/hosts :

192.168.1.200 srv1Nous spĂŠcifions le hostname dans le fichier /,etc/hostname en y mettant le nom ÂŤÂ srv1Â Âť.

Nous lançons la commande hostname :

hostname srv1Nous fermons et rouvrons la session pour prendre en compte le nouveau nom.

Nous installons ensuite le serveur de temps, indispensable à la synchronisation correcte entre diffÊrentes machines :

apt-get install ntp ntpdateEnsuite, nous configurons SSH afin de permettre une connexion par clĂŠ. Dâabord, nous gĂŠnĂŠrons une clĂŠ avec la commande ssh-keygen :

root@srv1:~# ssh-keygen

Generating public/private rsa key pair.

Enter file in which to save the key (/root/.ssh/id_rsa):

/root/.ssh/id_rsa already exists.

Overwrite (y/n)? ^C

root@srv1:~# rm .ssh/* -rf

root@srv1:~# ssh-keygen

Generating public/private rsa key pair.

Enter file in which to save the key (/root/.ssh/id_rsa):

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /root/.ssh/id_rsa.

Your public key has been saved in /root/.ssh/id_rsa.pub.

The key fingerprint is:

3c:38:bc:0d:54:45:13:2c:dc:bd:61:8c:24:d9:58:06 root@srv1

The key's randomart image is:

+---[RSA 2048]----+

| .E%O= |

| .=o=.= |

| . . . o |

| o o . |

| = S |

| = . |

| . . |

| |

| |

+-----------------+

root@srv1:~#Ensuite, nous copions la clÊ avec ssh-copy-id :

ssh-copy-id root@srv1

The authenticity of host 'srv1 (192.168.1.200)' can't be established.

ECDSA key fingerprint is 92:27:9f:61:14:19:63:85:28:d2:1b:88:4e:86:d6:08.

Are you sure you want to continue connecting (yes/no)? yes

/usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed

/usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys

root@srv1's password:

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'root@srv1'"

and check to make sure that only the key(s) you wanted were added.Toutes les commandes Ceph passent par SSH et le nom d'hĂ´te, il faut donc crĂŠer une clĂŠ SSH mĂŞme pour une communication locale.

Grâce à cela, la commande ssh root@srv1 devrait ouvrir un Shell, sans nÊcessitÊ de mot de passe, ce qui nous sera nÊcessaire pour les commandes suivantes.

1-4-3-1-2. Installation de ceph-deploy▲

Une fois les prĂŠrequis effectuĂŠs, nous allons installer et utiliser la commande ceph-deploy qui nous permettra de prĂŠparer et dĂŠployer notre cluster.

Nous commençons par tÊlÊcharger le fichier de signature de dÊpôt :

wget download.ceph.com/keys/release.ascNous installons celui-ci :

apt-key add release.ascNous ajoutons le dÊpôt dans /etc/apt/sources.list :

deb https://download.ceph.com/debian-luminous/ stretch mainPuis effectuons l'installation :

apt-get update

apt-get install ceph-deploy1-4-3-1-3. Configuration▲

Nous crÊons un dossier qui contiendra les fichiers de configuration du cluster :

mkdir cephdeploy

cd cephdeployNous crÊons notre cluster :

ceph-deploy new srv1La console nous retournera les informations suivantes :

[ceph_deploy.conf][DEBUG ] found configuration file at: /root/.cephdeploy.conf

[ceph_deploy.cli][INFO ] Invoked (1.5.39): /usr/bin/ceph-deploy new srv1

[ceph_deploy.cli][INFO ] ceph-deploy options:

[ceph_deploy.cli][INFO ] username : None

[ceph_deploy.cli][INFO ] verbose : False

[ceph_deploy.cli][INFO ] overwrite_conf : False

[ceph_deploy.cli][INFO ] quiet : False

[ceph_deploy.cli][INFO ] cd_conf : <ceph_deploy.conf.cephdeploy.Conf instance at 0x7f2db686dc68>

[ceph_deploy.cli][INFO ] cluster : ceph

[ceph_deploy.cli][INFO ] ssh_copykey : True

[ceph_deploy.cli][INFO ] mon : ['srv1']

[ceph_deploy.cli][INFO ] func : <function new at 0x7f2db6843cf8>

[ceph_deploy.cli][INFO ] public_network : None

[ceph_deploy.cli][INFO ] ceph_conf : None

[ceph_deploy.cli][INFO ] cluster_network : None

[ceph_deploy.cli][INFO ] default_release : False

[ceph_deploy.cli][INFO ] fsid : None

[ceph_deploy.new][DEBUG ] Creating new cluster named ceph

[ceph_deploy.new][INFO ] making sure passwordless SSH succeeds

[srv1][DEBUG ] connected to host: srv1

[srv1][DEBUG ] detect platform information from remote host

[srv1][DEBUG ] detect machine type

[srv1][DEBUG ] find the location of an executable

[srv1][INFO ] Running command: /bin/ip link show

[srv1][INFO ] Running command: /bin/ip addr show

[srv1][DEBUG ] IP addresses found: [u'192.168.1.200']

[ceph_deploy.new][DEBUG ] Resolving host srv1

[ceph_deploy.new][DEBUG ] Monitor srv1 at 192.168.1.200

[ceph_deploy.new][DEBUG ] Monitor initial members are ['srv1']

[ceph_deploy.new][DEBUG ] Monitor addrs are ['192.168.1.200']

[ceph_deploy.new][DEBUG ] Creating a random mon key...

[ceph_deploy.new][DEBUG ] Writing monitor keyring to ceph.mon.keyring...

[ceph_deploy.new][DEBUG ] Writing initial config to ceph.conf...

root@srv1:~/cephdeploy#Ceci va crÊer les fichiers :

- ceph.conf ;

- ceph-deploy-ceph.log ;

- ceph.mon.keyring.

le fichier ceph.conf contient :

[global]

fsid = 85967fe2-3f08-4e0b-9f3c-ca6647776383

mon_initial_members = srv1

mon_host = 192.168.1.200

auth_cluster_required = cephx

auth_service_required = cephx

auth_client_required = cephxDans lequel on ajoute :

osd pool default size = 2

osd pool default min size = 1

public_network = 192.168.1.0/24

cluster_network = 192.168.1.0/24C'est ce fichier qui contiendra la configuration complète du cluster. à ce stade, il n'y a qu'une machine avec les rÊglages minimums nÊcessaires au dÊmarrage. Ce fichier sera complÊtÊ au fur et à mesure de l'avancÊe dans le chapitre et de l'ajout des modules/machines.

Ceci va nous permettre de crĂŠer un pool OSD Ă deux disques et permettre l'utilisation avec un seul nĹud (en mode dĂŠgradĂŠ).

Les lignes public_network/cluster_network permettent de gĂŠrer les rĂŠseaux autorisĂŠs pour le dialogue entre les entitĂŠs Ceph. Dans notre cas, il n'y a aucune sĂŠparation ce qui n'est pas recommandĂŠ en production.

Nous installons ceph-deploy sur notre premier nĹud :

ceph-deploy install srv1Lire les logs peut permettre de comprendre les opĂŠrations dĂŠclenchĂŠes. Cela pourra vous ĂŞtre utile si vous comptez utiliser le service. Si vous ne lisez ce chapitre qu'Ă titre de dĂŠcouverte ou de veille technologique, vous pouvez passer directement Ă la suite.

Voici un exemple des logs affichÊs :

Debian GNU/Linux 8

srv1 login: root

Password:

Last login: Fri Nov 16 18:45:59 CET 2018 from srv1 on pts/1

Linux srv1 3.16.0-4-amd64 #1 SMP Debian 3.16.51-3 (2017-12-13) x86_64

The programs included with the Debian GNU/Linux system are free software;

the exact distribution terms for each program are described in the

individual files in /usr/share/doc/*/copyright.

Debian GNU/Linux comes with ABSOLUTELY NO WARRANTY, to the extent

permitted by applicable law.

root@srv1:~# apt-get install ca-certificates apt-transport-https

Lecture des listes de paquets... Fait

Construction de l'arbre des dĂŠpendances

Lecture des informations d'ĂŠtat... Fait

apt-transport-https est dĂŠjĂ la plus rĂŠcente version disponible.

ca-certificates est dĂŠjĂ la plus rĂŠcente version disponible.

0 mis Ă jour, 0 nouvellement installĂŠs, 0 Ă enlever et 24 non mis Ă jour.

root@srv1:~# ceph-deploy install srv1

[ceph_deploy.conf][DEBUG ] found configuration file at: /root/.cephdeploy.conf

[ceph_deploy.cli][INFO ] Invoked (1.5.39): /usr/bin/ceph-deploy install srv1

[ceph_deploy.cli][INFO ] ceph-deploy options:

[ceph_deploy.cli][INFO ] verbose : False

[ceph_deploy.cli][INFO ] testing : None

[ceph_deploy.cli][INFO ] cd_conf : <ceph_deploy.conf.cephdeploy.Conf instance at 0x7fd903c207a0>

[ceph_deploy.cli][INFO ] cluster : ceph

[ceph_deploy.cli][INFO ] dev_commit : None

[ceph_deploy.cli][INFO ] install_mds : False

[ceph_deploy.cli][INFO ] stable : None

[ceph_deploy.cli][INFO ] default_release : False

[ceph_deploy.cli][INFO ] username : None

[ceph_deploy.cli][INFO ] adjust_repos : True

[ceph_deploy.cli][INFO ] func : <function install at 0x7fd904063410>

[ceph_deploy.cli][INFO ] install_mgr : False

[ceph_deploy.cli][INFO ] install_all : False

[ceph_deploy.cli][INFO ] repo : False

[ceph_deploy.cli][INFO ] host : ['srv1']

[ceph_deploy.cli][INFO ] install_rgw : False

[ceph_deploy.cli][INFO ] install_tests : False

[ceph_deploy.cli][INFO ] repo_url : None

[ceph_deploy.cli][INFO ] ceph_conf : None

[ceph_deploy.cli][INFO ] install_osd : False

[ceph_deploy.cli][INFO ] version_kind : stable

[ceph_deploy.cli][INFO ] install_common : False

[ceph_deploy.cli][INFO ] overwrite_conf : False

[ceph_deploy.cli][INFO ] quiet : False

[ceph_deploy.cli][INFO ] dev : master

[ceph_deploy.cli][INFO ] nogpgcheck : False

[ceph_deploy.cli][INFO ] local_mirror : None

[ceph_deploy.cli][INFO ] release : None

[ceph_deploy.cli][INFO ] install_mon : False

[ceph_deploy.cli][INFO ] gpg_url : None

[ceph_deploy.install][DEBUG ] Installing stable version jewel on cluster ceph hosts srv1

[ceph_deploy.install][DEBUG ] Detecting platform for host srv1 ...

[srv1][DEBUG ] connected to host: srv1

[srv1][DEBUG ] detect platform information from remote host

[srv1][DEBUG ] detect machine type

[ceph_deploy.install][INFO ] Distro info: debian 8.10 jessie

[srv1][INFO ] installing Ceph on srv1

[srv1][INFO ] Running command: env DEBIAN_FRONTEND=noninteractive DEBIAN_PRIORITY=critical apt-get --assume-yes -q --no-install-recommends install ca-certificates apt-transport-https

[srv1][DEBUG ] Lecture des listes de paquetsâŚ

[srv1][DEBUG ] Construction de l'arbre des dĂŠpendancesâŚ

[srv1][DEBUG ] Lecture des informations d'ĂŠtatâŚ

[srv1][DEBUG ] apt-transport-https est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] ca-certificates est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] 0 mis Ă jour, 0 nouvellement installĂŠs, 0 Ă enlever et 24 non mis Ă jour.

[srv1][INFO ] Running command: wget -O release.asc https://download.ceph.com/keys/release.asc

[srv1][WARNIN] --2018-11-16 19:30:22-- https://download.ceph.com/keys/release.asc

[srv1][WARNIN] RÊsolution de download.ceph.com (download.ceph.com)⌠158.69.68.124, 2607:5300:201:2000::3:58a1

[srv1][WARNIN] Connexion à download.ceph.com (download.ceph.com)|158.69.68.124|:443⌠connectÊ.

[srv1][WARNIN] requête HTTP transmise, en attente de la rÊponse⌠200 OK

[srv1][WARNIN] Taille : 1645 (1,6K) [application/octet-stream]

[srv1][WARNIN] Sauvegarde en :  release.asc 

[srv1][WARNIN]

[srv1][WARNIN] 0K . 100% 27,7M=0s

[srv1][WARNIN]

[srv1][WARNIN] 2018-11-16 19:30:23 (27,7 MB/s) â ÂŤÂ release.asc  sauvegardĂŠ [1645/1645]

[srv1][WARNIN]

[srv1][INFO ] Running command: apt-key add release.asc

[srv1][DEBUG ] OK

[srv1][DEBUG ] add deb repo to /etc/apt/sources.list.d/

[srv1][INFO ] Running command: env DEBIAN_FRONTEND=noninteractive DEBIAN_PRIORITY=critical apt-get --assume-yes -q update

[srv1][DEBUG ] Ign http://ftp.fr.debian.org jessie InRelease

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie-updates InRelease

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/updates InRelease

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie Release.gpg

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie Release

[srv1][DEBUG ] RÊception de : 1 http://ftp.fr.debian.org jessie-updates/main amd64 Packages/DiffIndex [11,8 kB]

[srv1][DEBUG ] RÊception de : 2 http://ftp.fr.debian.org jessie-updates/main Translation-en/DiffIndex [3 688 B]

[srv1][DEBUG ] Atteint https://download.ceph.com jessie InRelease

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/updates/main amd64 Packages

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/updates/main Translation-en

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/main amd64 Packages

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/main Translation-fr

[srv1][DEBUG ] RÊception de : 3 https://download.ceph.com jessie/main Translation-fr_FR [178 B]

[srv1][DEBUG ] Atteint http://ftp.fr.debian.org jessie/main Translation-en

[srv1][DEBUG ] RÊception de : 4 https://download.ceph.com jessie/main Translation-fr [178 B]

[srv1][DEBUG ] RÊception de : 5 https://download.ceph.com jessie/main Translation-en [178 B]

[srv1][DEBUG ] Atteint https://download.ceph.com jessie/main amd64 Packages

[srv1][DEBUG ] RÊception de : 6 https://download.ceph.com jessie/main Translation-fr_FR [178 B]

[srv1][DEBUG ] RÊception de : 7 https://download.ceph.com jessie/main Translation-fr [178 B]

[srv1][DEBUG ] RÊception de : 8 https://download.ceph.com jessie/main Translation-en [178 B]

[srv1][DEBUG ] RÊception de : 9 https://download.ceph.com jessie/main Translation-fr_FR [178 B]

[srv1][DEBUG ] RÊception de : 10 https://download.ceph.com jessie/main Translation-fr [178 B]

[srv1][DEBUG ] RÊception de : 11 https://download.ceph.com jessie/main Translation-en [178 B]

[srv1][DEBUG ] RÊception de : 12 https://download.ceph.com jessie/main Translation-fr_FR [178 B]

[srv1][DEBUG ] RÊception de : 13 https://download.ceph.com jessie/main Translation-fr [178 B]

[srv1][DEBUG ] RÊception de : 14 https://download.ceph.com jessie/main Translation-en [178 B]

[srv1][DEBUG ] RÊception de : 15 https://download.ceph.com jessie/main Translation-fr_FR [178 B]

[srv1][DEBUG ] Ign https://download.ceph.com jessie/main Translation-fr_FR

[srv1][DEBUG ] RÊception de : 16 https://download.ceph.com jessie/main Translation-fr [178 B]

[srv1][DEBUG ] Ign https://download.ceph.com jessie/main Translation-fr

[srv1][DEBUG ] RÊception de : 17 https://download.ceph.com jessie/main Translation-en [178 B]

[srv1][DEBUG ] Ign https://download.ceph.com jessie/main Translation-en

[srv1][DEBUG ] 15,5 ko rĂŠceptionnĂŠs en 5s (3 032 o/s)

[srv1][DEBUG ] Lecture des listes de paquetsâŚ

[srv1][WARNIN] W: Duplicate sources.list entry https://download.ceph.com/debian-jewel/ jessie/main amd64 Packages (/var/lib/apt/lists/download.ceph.com_debian-jewel_dists_jessie_main_binary-amd64_Packages)

[srv1][WARNIN] W: Vous pouvez lancer  apt-get update  pour corriger ces problèmes.

[srv1][INFO ] Running command: env DEBIAN_FRONTEND=noninteractive DEBIAN_PRIORITY=critical apt-get --assume-yes -q --no-install-recommends install -o Dpkg::Options::=--force-confnew ceph ceph-osd ceph-mds ceph-mon radosgw

[srv1][DEBUG ] Lecture des listes de paquetsâŚ

[srv1][DEBUG ] Construction de l'arbre des dĂŠpendancesâŚ

[srv1][DEBUG ] Lecture des informations d'ĂŠtatâŚ

[srv1][DEBUG ] ceph est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] ceph-mds est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] ceph-mon est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] ceph-osd est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] radosgw est dĂŠjĂ la plus rĂŠcente version disponible.

[srv1][DEBUG ] 0 mis Ă jour, 0 nouvellement installĂŠs, 0 Ă enlever et 24 non mis Ă jour.

[srv1][INFO ] Running command: ceph --version

[srv1][DEBUG ] ceph version 10.2.11 (e4b061b47f07f583c92a050d9e84b1813a35671e)

root@srv1:~#Dans les logs, nous pouvons voir ce qu'il se passe :

- connexion SSH sur srv1Â ;

- tĂŠlĂŠchargement de la clĂŠ de dĂŠpĂ´t Ceph (nous l'avons dĂŠjĂ fait pour l'installation de ceph-deploy, inutile ici, mais nĂŠcessaire pour le dĂŠploiement de Ceph sur une autre machine)Â ;

- ajout de la clĂŠ avec apt-key (dĂŠjĂ fait)Â ;

- ajout du dĂŠpĂ´t dans /etc/apt/sources.list.d (en doublon avec ce qui a dĂŠjĂ ĂŠtĂŠ fait pour installer ceph-deploy, nous voyons un avertissement Ă ce sujet)Â ;

- installation des paquets nĂŠcessaires.

La commande se termine par l'appel de ceph âversion.

La commande est prĂŠvue pour installer tout ce qu'il faut sur n'importe quelle machine via SSH.

1-4-3-1-4. CrĂŠation d'un moniteur▲

Pour gĂŠrer notre cluster, nous avons besoin dâun moniteur. La crĂŠation sâeffectue avec la commande :

ceph-deploy mon create-initialQui retourne :

[ceph_deploy.conf][DEBUG ] found configuration file at: /root/.cephdeploy.conf

[ceph_deploy.cli][INFO ] Invoked (1.5.39): /usr/bin/ceph-deploy mon create-initial

[ceph_deploy.cli][INFO ] ceph-deploy options:

[ceph_deploy.cli][INFO ] username : None

[ceph_deploy.cli][INFO ] verbose : False

[ceph_deploy.cli][INFO ] overwrite_conf : False

[ceph_deploy.cli][INFO ] subcommand : create-initial

[ceph_deploy.cli][INFO ] quiet : False

[ceph_deploy.cli][INFO ] cd_conf : <ceph_deploy.conf.cephdeploy.Conf instance at 0x7faf0fb69fc8>

[ceph_deploy.cli][INFO ] cluster : ceph

[ceph_deploy.cli][INFO ] func : <function mon at 0x7faf0ffd4500>

[ceph_deploy.cli][INFO ] ceph_conf : None

[ceph_deploy.cli][INFO ] keyrings : None

[ceph_deploy.cli][INFO ] default_release : False

[ceph_deploy.mon][DEBUG ] Deploying mon, cluster ceph hosts srv1

[ceph_deploy.mon][DEBUG ] detecting platform for host srv1 ...

[srv1][DEBUG ] connected to host: srv1

[srv1][DEBUG ] detect platform information from remote host

[srv1][DEBUG ] detect machine type

[srv1][DEBUG ] find the location of an executable

[ceph_deploy.mon][INFO ] distro info: debian 8.10 jessie

[srv1][DEBUG ] determining if provided host has same hostname in remote

[srv1][DEBUG ] get remote short hostname

[srv1][DEBUG ] deploying mon to srv1

[srv1][DEBUG ] get remote short hostname

[srv1][DEBUG ] remote hostname: srv1

[srv1][DEBUG ] write cluster configuration to /etc/ceph/{cluster}.conf

[srv1][DEBUG ] create the mon path if it does not exist

[srv1][DEBUG ] checking for done path: /var/lib/ceph/mon/ceph-srv1/done

[srv1][DEBUG ] done path does not exist: /var/lib/ceph/mon/ceph-srv1/done

[srv1][INFO ] creating keyring file: /var/lib/ceph/tmp/ceph-srv1.mon.keyring

[srv1][DEBUG ] create the monitor keyring file

[srv1][INFO ] Running command: ceph-mon --cluster ceph --mkfs -i srv1 --keyring /var/lib/ceph/tmp/ceph-srv1.mon.keyring --setuser 64045 --setgroup 64045

[srv1][DEBUG ] ceph-mon: renaming mon.noname-a 192.168.1.200:6789/0 to mon.srv1

[srv1][DEBUG ] ceph-mon: set fsid to 85967fe2-3f08-4e0b-9f3c-ca6647776383

[srv1][DEBUG ] ceph-mon: created monfs at /var/lib/ceph/mon/ceph-srv1 for mon.srv1

[srv1][INFO ] unlinking keyring file /var/lib/ceph/tmp/ceph-srv1.mon.keyring

[srv1][DEBUG ] create a done file to avoid re-doing the mon deployment

[srv1][DEBUG ] create the init path if it does not exist

[srv1][INFO ] Running command: systemctl enable ceph.target

[srv1][INFO ] Running command: systemctl enable ceph-mon@srv1

[srv1][WARNIN] Created symlink from /etc/systemd/system/ceph-mon.target.wants/ceph-mon@srv1.service to /lib/systemd/system/ceph-mon@.service.

[srv1][INFO ] Running command: systemctl start ceph-mon@srv1

[srv1][INFO ] Running command: ceph --cluster=ceph --admin-daemon /var/run/ceph/ceph-mon.srv1.asok mon_status

[srv1][DEBUG ] ********************************************************************************

[srv1][DEBUG ] status for monitor: mon.srv1

[srv1][DEBUG ] {

[srv1][DEBUG ] "election_epoch": 3,

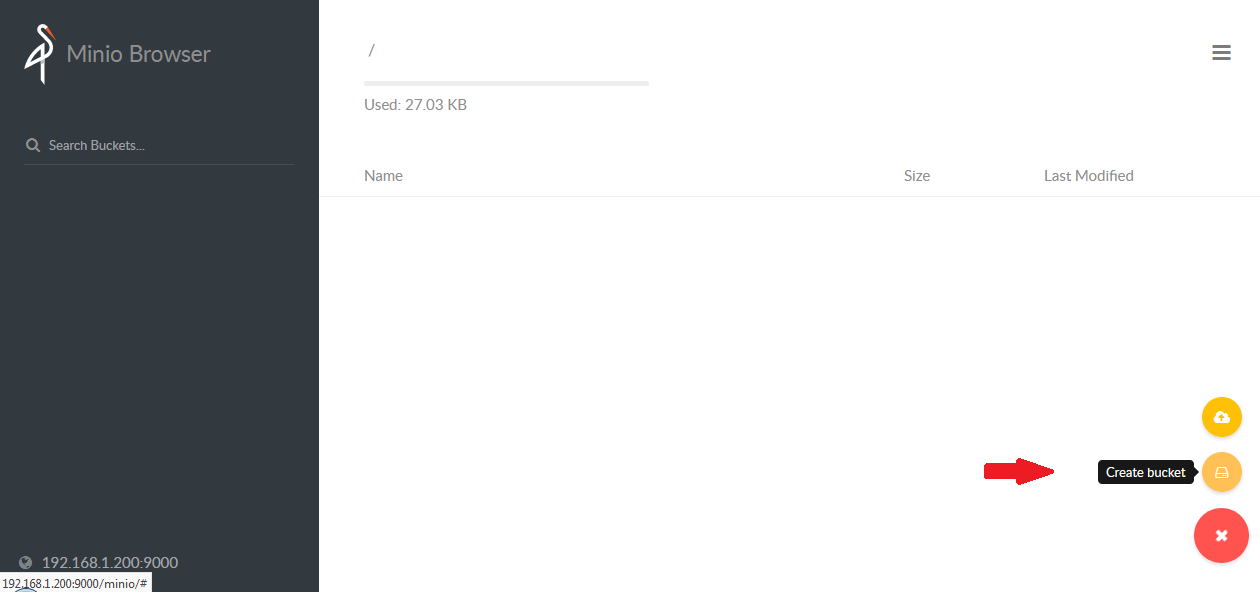

[srv1][DEBUG ] "extra_probe_peers": [],